机器人的“愤怒”很可怕!

据英国《卫报》报道,近日,在莫斯科国际象棋公开赛上,象棋机器人在对弈过程中,突然抓住并折断对面七岁小男孩的手指。主办方称,是小男孩没等机器人落完子就抢跑,因此引发机械臂做出反应。

这个说法显然不能打消人们的疑虑,拥有人工智能的机器人不管什么原因,也不能伤害人类,这次机器人“发脾气”夹断手指,下次还会做出什么动作?

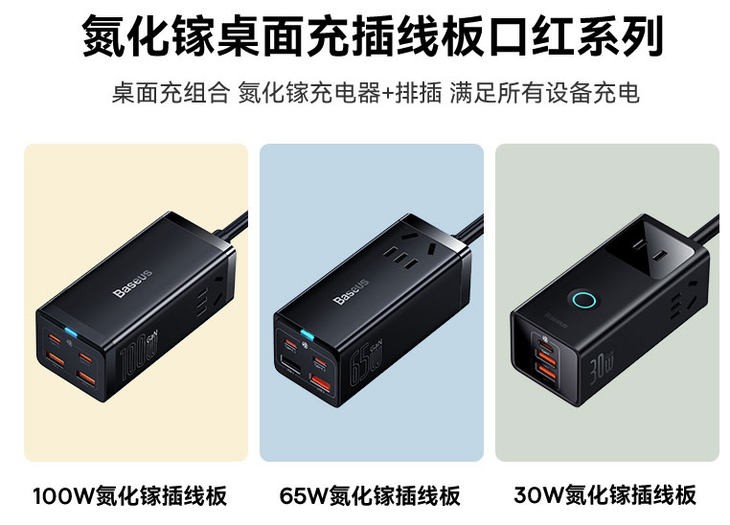

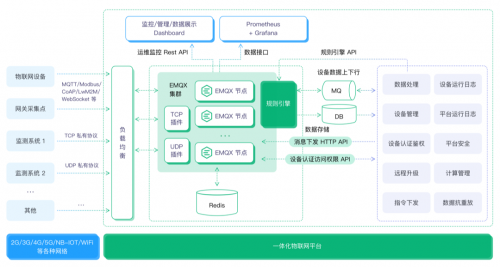

(相关资料图)

(相关资料图)

归根到底,人类科学家研究人工智能技术,是让机器人能更好地服务人类自身,更多地承担人类劳动,相比自然界的其他生物,机器人作为“人类之仆”显然更有想象空间。

从诞生之日起,人们就对机器人又爱又防,担忧的就是机器人自我意识苏醒后,脱离人类控制,给人类带来浩劫。

知名科幻作家阿西莫夫在小说集《我,机器人》中提出了流传后世的机器人三定律:

第一定律:机器人不得伤害人类个体,或者目睹人类个体将遭受危险而袖手不管

第二定律:机器人必须服从人给予它的命令,当该命令与第一定律冲突时例外

第三定律:机器人在不违反第一、第二定律的情况下要尽可能保护自己的生存

三条定律相对圆融地解决了机器人与人类的关系,至于后来补充的所谓第零定律: 机器人必须保护人类的整体利益不受伤害,就有些含糊了,这一条人类自己都还没捋明白。

让机器人更先进、更智能,这是数十年来科学家们研究的主流,据统计,我国关于人工智能的专利已经超过44万件。

不过,让机器人更向善、更懂道德,研究者相对就少多了。

小编在查询知产宝专利库时发现,华南师范大学软件学院的朱定局教授是其中一位专注研究者,华南师范大学也是人工智能领域主要申请主体之一,近年来申请量稳定增高。

他的人工智能道德伦理训练系列专利,比较典型的有以下这些:

这些专利,都申请于2020年6月以后,多数还处于公开阶段,算是该领域比较前沿的研究成果。

朱教授在研究人工智能伦理防范时,核心思想是“以人类道德引领人工智能发展”(出自“以人类道德为行为依据的人工智能方法和机器人”专利)。

以人类道德规范为参照物,朱教授对人工智能机器人建立了相比三定律更为细致的伦理规范体系,如要求机器人反性别歧视、种族歧视,防止机器人为虎作伥,机器人能区分善恶(如警察和罪犯),在面对两难情况(如AI自动驾驶中,AI只有两个选择,要么继续向前方行驶,要么拐弯行驶,前方是20个人,拐弯是1个人)下尽量减少损害等。

值得一提的是,这些规则、理念,仅是作为专利的实施例而存在的,如果光是列举规则,那么诸多文科生甚至文化水平不高的人也能凭借朴素的道德观念做出这些,更有价值的部分,在于专利的权利要求和说明部分。

上述专利,均有算法和深度学习模型进行支撑,如“善恶分明的人工智能伦理规则实现方法、系统和机器人”专利中,为了使机器人达到 不得伤害不伤害人

类的人类,或因不作为而使不伤害人类的人类受到伤害的效果,需要建立深度学习模型,对机器人进行反复的训练和测试,将事件场景作为深度学习模型的输入,将所述事件场景中的人类作为深度学习模型的预期输出,对深度学习模型进行训练和测试,对人工智能机器人进行多轮训练。

人工智能是否会自我觉醒,又是否会衍生出道德?

朱教授在发明专利中这么说:

既然人类可以自主地发展出人类的道德,那么人工智能在具备自主意识之后是否能发展出自己的道德?是完全可能的……人类的道德属于外在强加给人工智能的道德,不是人工智能在追求美好生活过程中自然发展出来的道德,必然会在人工智能追求自我解放的过程中所突破甚至抛弃。所以人类只有把具备自主意识之后的人工智能也看作人类(人类创造的人类),人工智能才有可能与人类在追求共同的美好生活的过程中遵循同样的人类道德。

本文来自微信公众号 “知产力”(ID:zhichanli),作者:玄袂,36氪经授权发布。